Qualcomm® AI Hub

Qualcomm® AI Hub は、視覚、音声、音声のユースケースに対して機械学習モデルをオンデバイスで最適化、検証、および展開するのに役立ちます。

Qualcomm® AI Hub を使用すると、次のことができます:

PyTorch や ONNX などのフレームワークから学習済みモデルを Qualcomm® デバイス上で最適化されたオンデバイスパフォーマンスに変換します。

オンデバイスでモデルをプロファイルして、ランタイム、ロード時間、計算ユニットの利用率などの詳細なメトリクスを取得します。

オンデバイス推論を実行して数値的な正確性を検証します。

Qualcomm® AI Engine Direct, TensorFlow Lite, または ONNX Runtime を使用してモデルを簡単に展開します。

Qualcomm® AI Hub Models リポジトリには、Qualcomm® AI Hub を使用して Qualcomm® デバイス上でモデルを最適化、検証、および展開するための例モデルが含まれています。

それはどのように機能しますか?

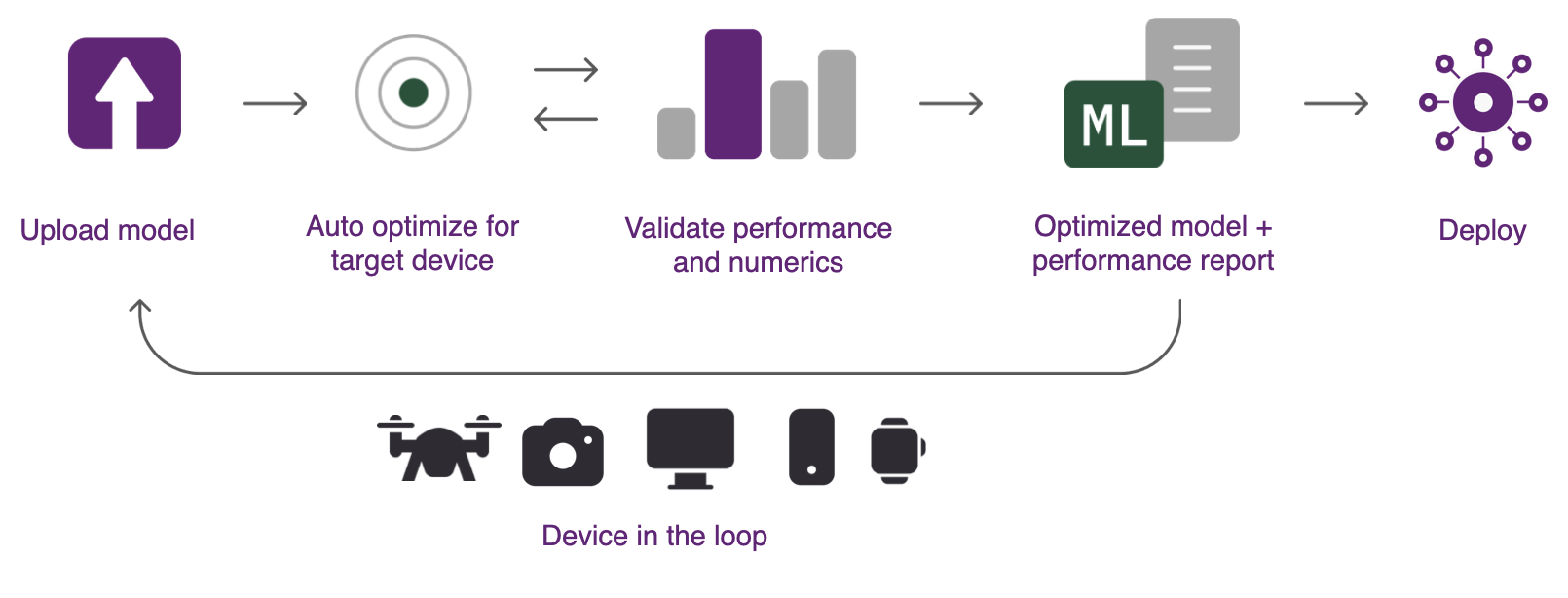

Qualcomm® AI Hub は、ソースフレームワークからデバイスランタイムへのモデル変換を自動的に処理し、ハードウェア対応の最適化を適用し、物理的なパフォーマンス/数値検証を行います。システムはクラウドでデバイスを自動的にプロビジョニングして、オンデバイスプロファイルおよび推論を実行します。次の画像は、Qualcomm® AI Hub を使用してモデルを分析するために取られるステップを示しています。

Qualcomm® AI Hub を使用するには、次のものが必要です:

PyTorch, TorchScript, ONNX または TensorFlow Lite 形式の学習済みモデル。

デプロイメントターゲットに関する実務的な知識が必要です。これは、特定のデバイス(例:Samsung Galaxy S23 Ultra)または複数のデバイス範囲を指します。

学習済みモデルを|qti|デバイスに展開するために使用できる次の3つのステップ:

- ステップ1:オンデバイス実行のための最適化

システムには、選択したターゲットプラットフォームに対して学習済みモデルを最適化できるホストコンパイラツールのコレクションが含まれています。ハードウェア対応の最適化が行われ、ターゲットハードウェアが最適に利用されるようにします。モデルは Qualcomm® AI Engine Direct, TensorFlow Lite, または ONNX Runtime で展開するために最適化できます。すべての形式変換は自動的に処理されます。

- ステップ2:オンデバイスの推論を実行

システムは、モデルレイヤーの計算ユニットへのマッピング、推論レイテンシー、ピークメモリ使用量などのメトリクスを収集するために物理デバイス上でコンパイル済みモデルを実行できます。ツールは、数値的な正確性を検証するために入力データを使用してモデルを実行することもできます。すべての分析はクラウドで自動的にプロビジョニングされた実際のハードウェアで行われます。

- ステップ3:デプロイ

モデルの結果は Qualcomm® AI Hub に表示され、モデルのパフォーマンスを理解し、さらなる改善の機会を提供するための洞察を提供します。最適化済みモデルは、さまざまなプラットフォームに展開するために利用可能です。

目次