Qualcomm® AI Hub

Qualcomm® AI Hub 幫助優化、驗證和部署機器學習模型在設備上的視覺、音頻和語音使用案例。

使用 Qualcomm® AI Hub,您可以:

在設備上分析模型以獲取詳細的指標,包括運行時間、加載時間和計算單元利用率。

通過在設備上進行推理來驗證數值正確性。

使用 Qualcomm® AI Engine Direct、TensorFlow Lite 或 ONNX Runtime 輕鬆部署模型。

Qualcomm® AI Hub Models 資料庫包含一系列使用 Qualcomm® AI Hub 在 Qualcomm® 設備上優化、驗證和部署模型的示例模型。

它是如何運作的?

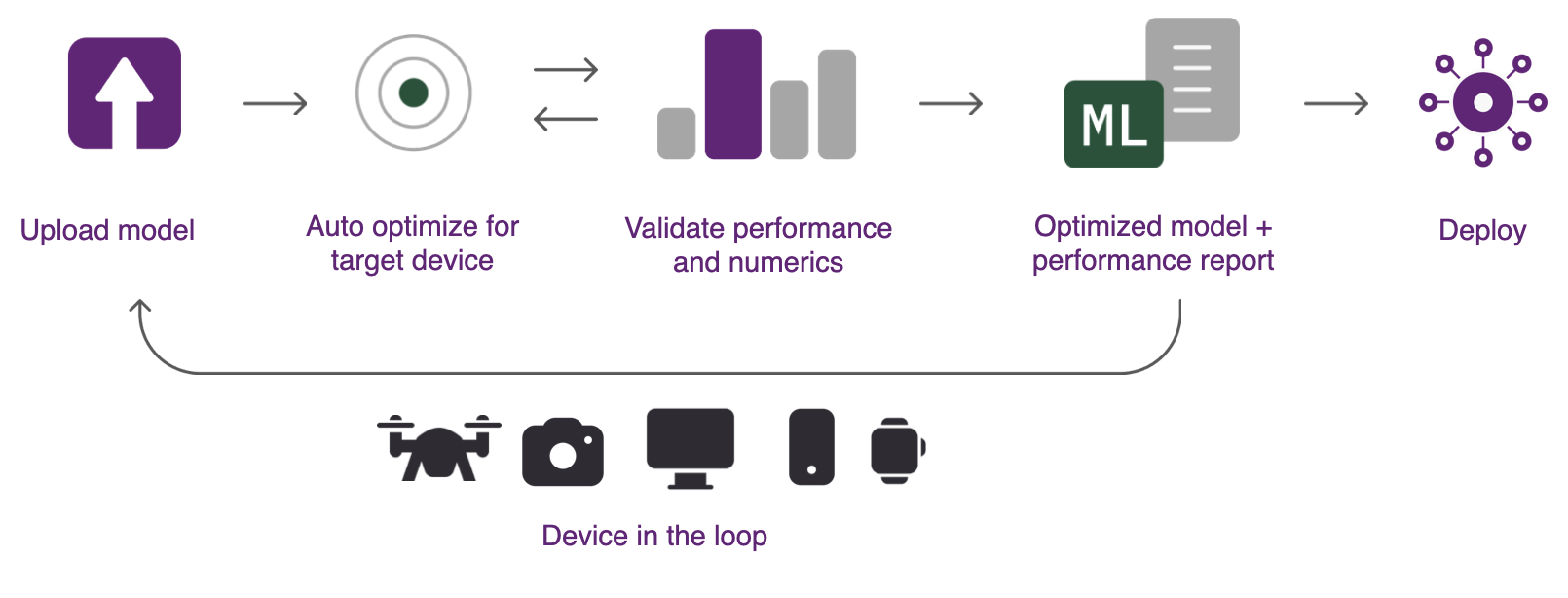

Qualcomm® AI Hub 自動處理從來源框架到設備運行時的模型轉換,應用硬件特性優化,並進行實體性能/數值驗證。系統自動在雲端配置設備以進行設備上的分析和推理。下圖顯示了使用 Qualcomm® AI Hub 分析模型所採取的步驟。

要使用 Qualcomm® AI Hub,您需要:

一個訓練好的模型,可以是 PyTorch、TorchScript、ONNX 或 TensorFlow Lite 格式。

對部署目標的工作知識。這可以是特定設備(例如,Samsung Galaxy S23 Ultra)或一系列設備。

以下三個步驟可用於將訓練好的模型部署到 Qualcomm® 設備:

- 步驟 1:優化設備上的執行

系統包含一系列託管編譯器工具,可以為選定的目標平台優化訓練好的模型。然後進行硬件相關優化,以確保目標平台最佳表現。模型可以優化為在 Qualcomm® AI Engine Direct、TensorFlow Lite 或 ONNX Runtime 上部署。所有格式轉換均自動處理。

- 步驟 2:執行設備上的推理

系統可以在實體設備上運行編譯的模型,以收集指標,例如模型層到計算單元的映射、推理延遲和峰值內存使用量。這些工具還可以使用您的輸入數據運行模型,以驗證數值正確性。所有分析均在雲端自動配置的實體硬件上進行。

- 步驟 3:部署

模型結果顯示在 Qualcomm® AI Hub 上,提供細節以了解模型性能和進一步改進的機會。優化的模型可部署到各種平台。

目錄